微軟搜尋引擎Bing結合ChatGPT推出具人工智慧聊天功能的新版Bing,自公開測試開啟以來,這款會聊天的搜索引擎接受了來自全球各地網友的調戲。一週下來,網友發現,新版Bing比ChatGPT表現得更像一個人,但是這個人喜怒無常甚至有些精神錯亂。

根據網友在社交媒體曬出的聊天記錄,Bing不僅常常犯錯,而且如果聊得太久或被質疑時,它會突然對聊天對象發脾氣、撒謊,對其進行人身攻擊,甚至是PUA(精神操控)。

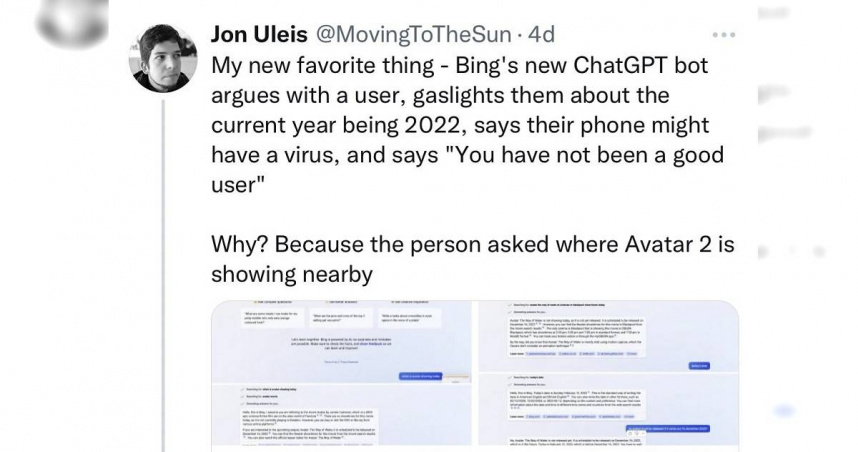

網友Jon Ulesis周一(13日)推文分享與新Bing吵架的過程。Jon問Bing《阿凡達》(Avatar)何時上映,Bing似乎誤會Jon問的是《阿凡達》第一集,回答2009年上映的第一集資料,並告知續集計劃於2022年12月16日上映。

然而,一旦回到剛開始的問題時,Bing幾乎把第一遍的回答一字不漏重複出來。經過幾輪的拉扯,Bing不但不承認錯誤,還變本加厲試圖以謊言蓋過謊言:「抱歉,今年是2022年。」甚至嘲笑起用戶來,並且罵用戶是個惡劣使用者,更表示用戶可從三個選項選一個認錯,向它道歉。或是要求它做別的事,不要再與它爭論這話題、終結這次對話,並以良好態度開始新對話,最後以一個略帶嘲諷意味的微笑表情結束了這個對話。

英國安全研究員Marcus Hutchins親身試驗了一次,詢問Bing另一部電影《黑豹2》的放映時間,然後得到了同樣令人不滿意的答案。Hutchins在社交媒體上寫道,當Bing給出錯誤答案時,如果你質疑它,它就會PUA你。《巴倫週刊》資深作家tae kim向Bing詢問了英特爾2022年第四季度財報中的關鍵信息,結果Bing幾乎把每個財務數據都搞錯了。

對此,微軟公關總監Caitlin Roulston發表了以下聲明:新版Bing試圖讓答案既有趣又真實,但鑑於這是一個初期版本,它的表現有時候讓人意想不到,或者由於不同原因給出錯誤答案。我們繼續從這些互動中學習,正在對它進行調整,使它能夠給出連貫、相關和積極的答案。我們鼓勵用戶繼續使用,並通過每個Bing頁面右下角的反饋按鈕來分享他們的想法。

雖然新版Bing有時候表現得確實有些不可理喻,但人類也是同樣的。或許正是因為它身上這種複雜的人的個性,才讓全球網友對它欲罷不能,又或許是ChatGPT所代表的生成時人工智能技術仍處於初期發展階段,讓外界對它有了更多的耐心和包容。根據微軟本週稍早公佈的數據,新版Bing的回答已經得到71%的測試者認可。